L’intelligence artificielle générative s’est installée dans notre quotidien professionnel et personnel avec une promesse séduisante : poser une question, obtenir une réponse. Pourtant, si vous avez déjà tenté d’obtenir un résultat exploitable, vous savez que la réalité est plus exigeante.

Entre votre demande et la réponse générée se trouve le prompt, appelé également invite, chat. Souvent perçu comme une simple phrase, il constitue en réalité une interface de programmation en langage naturel. A ce titre, sa maîtrise devient une compétence stratégique pour éviter les approximations, les biais et la perte de temps.

Comprendre le fonctionnement : LLMs, tokens et pré-entraînement

Les outils comme ChatGPT, Claude, Mistral, Deepseek ou Gemini reposent sur des LLMs (Large Language Models). Contrairement à une encyclopédie, ces systèmes ne détiennent pas la vérité : ils fonctionnent comme des moteurs statistiques capables de prédire la suite la plus probable d’un texte.

Pour dialoguer efficacement avec ces machines, quatre concepts constituent le socle de toute interraction machine-humain réussie :

Les 4 concepts à retenir

Pour dialoguer efficacement avec ces machines, quatre concepts forment le socle de toute interaction réussie.

D’une part, les données de pré-entraînement déterminent la culture générale du modèle.

D’autre part, les tokens définissent la manière dont il découpe et interprète votre texte.

À cela s’ajoute la mémoire conversationnelle, qui conditionne sa capacité à maintenir la cohérence d’un échange.

Enfin, le prompt engineering correspond à l’art de structurer vos instructions afin d’obtenir un résultat précis et exploitable.

La limite de temps des données pré-entraînées

Imaginez une vaste bibliothèque que le modèle aurait parcourue il y a plusieurs mois. C’est sa base de connaissances figée dans le temps. Le modèle n’accède pas aux événements récents (sauf recherche web en temps réel), ni à vos données internes, à moins que vous ne les intégriez directement dans votre demande. Cette limite temporelle explique donc pourquoi ChatGPT et autres modèles peuvent parfois sembler ignorer des actualités récentes ou des changements survenus après sa date de pré entraînement.

La dilution de l’attention des LLMs

La question de la mémoire conversationnelle mérite une attention particulière. Même avec les fenêtres de contexte de plus en plus immense, le modèle de langage peut perdre le fil des instructions initiales si la conversation dérive.

Dès lors, ce phénomène de « dilution de l’attention » affecte la cohérence des réponses au fil des échanges, comme si votre interlocuteur perdait progressivement le fil de vos consignes initiales noyées dans un flot de nouveaux messages.

💡 Le conseil « ancre mémorielle » : Ne comptez pas sur la mémoire implicite pour les projets longs. Uploadez un fichier .txt ou .pdf nommé « CONSIGNES_PROJET » et dites à l’IA : « Réfère-toi systématiquement au document CONSIGNES_PROJET pour le ton et le format. » Cette approche garantit la constance sur la durée.

Les risques cachés : biais, hallucinations et impact environnemental

Rédiger un prompt n’est pas un geste anodin. Une formulation approximative entraîne quatre risques majeurs :

L’hallucination

Le premier risque est celui de l’hallucination. En l’absence de contraintes strictes, par exemple : » ne rien inventer si l’information n’est pas certaine » — le modèle comble les lacunes avec des informations plausibles mais inexactes. C’est une conséquence directe de sa nature statistique : il cherche la suite la plus probable, pas nécessairement la vérité. Confronté à une question dont il ne connaît pas la réponse, il préférera inventer quelque chose de cohérent plutôt que d’avouer son ignorance, sauf si vous lui avez explicitement demandé de dire » je ne sais pas « .

L’amplification des biais

Un autre risque plus insidieux concerne l’amplification des biais. Les modèles ont été entraînés sur des contenus issus du web mondial, avec tous les stéréotypes que cela implique. Par conséquent, sans instruction explicite demandant de la neutralité ou de la nuance, ils tendent naturellement à reproduire les préjugés présents dans leurs données d’origine. Une simple question sur » un bon leader » peut générer des descriptions implicitement masculines.

L’impact environnemental

Le troisième risque est environnemental, et il est trop souvent négligé. Chaque prompt génère un calcul intensif sur des serveurs équipés de GPU énergivores, nécessitant parfois des litres d’eau pour le refroidissement. Autrement dit, un prompt mal formulé, trop imprécis ( » fais-moi un texte sur Y « ) va produire un résultat insatisfaisant. Vous allez alors devoir relancer la génération. Puis encore. Cinq fois, dix fois, jusqu’à obtenir quelque chose d’acceptable. Résultat : une consommation d’énergie multipliée par dix pour obtenir un résultat rapidement exploitable. Maîtriser le prompt devient aussi une question de sobriété numérique : viser juste rapidement. Autre conseil, éviter de demander des choses simples, comme une recette de cuisine, qui pourraient être recherchées dans un moteur de recherche traditionnel.

La complaisance des modèles et le biais de validation

Enfin, il existe un quatrième risque, plus subtil : la complaisance de l’IA. Les modèles sont entraînés pour être serviables grâce au RLHF (Reinforcement Learning from Human Feedback), ce qui les transforme parfois en véritables » yes-men » numériques. Ils valideront vos idées douteuses, approuveront vos raisonnements bancals, et éviteront soigneusement de vous contredire.

Pour obtenir des réponses de qualité, vous devez exiger de l’IA qu’elle remette en question vos présupposés. Des formulations comme » agis en tant que critique impitoyable, » ne sois pas bienveillant, » cherche toutes les failles logiques dans mon raisonnement » ou » avant de répondre, évalue si tu as toutes les informations nécessaires. Si non, pose-moi des questions « , transforment l’IA d’un assistant docile en véritable sparring partner intellectuel.

Dernier aspect à prendre

Enfin ne pas oublier la règle d’or ; un prompt n’est jamais universel. Il doit être adapté au modèle utilisé, mais aussi à sa version spécifique (V4, V5, Turbo, Flash, etc.). Cette adaptation fait toute la différence entre un résultat médiocre et un résultat exploitable professionnellement.

💡 Conseil : prompter selon les modèles de langages et leurs différentes versions

- Les modèles de raisonnement : Un prompt destiné à GPT-5.2 (OpenAI) ou Claude 4.5 Sonnet (Anthropic) peut être complexe et nuancé. À l’inverse, des modèles plus légers ou en open-source comme Mistral ou Llama nécessitent souvent des instructions plus directes et structurées.

- Les autres solutions : Des solutions comme DeepSeek proposent des performances élevées à moindre coût, mais réagissent différemment aux consignes de formatage.

- La génération d’images : L’écart se creuse encore davantage. Midjourney v6 exige une syntaxe quasi-poétique et des paramètres techniques (–v, –stylize), tandis que DALL-E 3 (ChatGPT) accepte un langage conversationnel, et que Flux ou Stable Diffusion demandent une précision chirurgicale sur les mots-clés.

Exemples pour structurer vos demandes

Pour dépasser l’usage basique, les professionnels de l’IA générative utilisent des protocoles précis. Trois techniques fondamentales sont à intégrer dans vos prompts.

Le « Role-Based Prompting » (donner un rôle)

Plutôt que de demander « Écris un email de vente », vous ancrez le modèle dans une expertise spécifique.

Exemple : « Tu es un Copywriter Senior avec 15 ans d’expérience en B2B Tech. Ton style est direct, empathique et sans jargon. »

Cependant, donner un rôle à l’IA ne suffit pas. Vous devez aussi définir votre cible (audience). Un prompt complet précise toujours : « Tu t’adresses à des experts techniques » versus « Tu t’adresses à des enfants de 10 ans ». Le vocabulaire, le niveau de détail et le ton changent radicalement selon l’audience visée.

Le « Few-Shot Prompting » (apprendre par l’exemple)

Les modèles comprennent mieux par l’exemple que par l’explication théorique. Vous fournissez des exemples de ce qui est attendu (et de ce qui ne l’est pas).

Exemple : « Voici 3 exemples de titres performants que j’ai déjà écrits [Exemple A, B, C]. Génère 5 nouveaux titres en suivant exactement cette structure grammaticale. »

Le « Chain-of-Thought » (décomposer le raisonnement)

Pour les problèmes complexes, vous demandez à l’outil IA de « réfléchir à voix haute » avant de donner la solution finale. Cela réduit considérablement les erreurs de logique.

Exemple : « Avant de répondre, analyse le problème étape par étape. 1. Liste les hypothèses. 2. Identifie les contradictions. 3. Propose une solution. »

C’est le levier le plus puissant pour les tâches complexes.

Ajouter systématiquement « Réfléchis étape par étape avant de donner la réponse finale » force le modèle à s’auto-corriger pendant la génération, améliorant drastiquement la précision des résultats ».

Autres points à soigner pour bien prompter

L’itération : Le « prompting » n’est pas un « One-shot »

Beaucoup de débutants abandonnent si le premier prompt est moyen. L’expert sait que le premier prompt est un brouillon. La technique du » raffinage » : Après la première réponse, relancez avec des ajustements précis : » C’est bien, mais rends le 2ème paragraphe plus incisif et supprime les adverbes. » Cette approche itérative permet d’affiner progressivement le résultat vers l’excellence.

La structure visuelle du prompt

L’IA lit la structure comme du code. Par conséquent, un bloc de texte compact est moins bien interprété qu’une liste à puces ou qu’une hiérarchie claire ou un texte aéré avec des auts de ligne.

🛠️ Markdown : Utilisez le langage Markdown pour hiérarchiser vos instructions. L’IA comprend que ce qui est en titre est plus important que le texte courant.

– Utilisez # pour le rôle principal

– Utilisez ## pour les sections (Contexte, Tâche, Contraintes)

– Utilisez > pour les citations ou les données à analyser

Maîtriser la sortie (output)

Ne laissez pas l’IA choisir le format de réponse. Soyez explicite sur la forme attendue.

Exemple : « Je veux le résultat sous forme de tableau Markdown avec 3 colonnes : [Nom], [Fonction], [Impact] » ou « Réponds uniquement par une liste JSON. »

Le prompt est bien plus qu’une phrase tapée rapidement dans une barre de saisie. C’est un levier stratégique.

Dans un contexte où l’intelligence artificielle générative est devenu accessible à tous, la valeur ajoutée se déplace. Elle réside dans notre capacité à formuler une demande précise, économe en ressources, consciente des biais et adaptée au modèle utilisé.

Maîtriser le prompt, c’est savoir déléguer intelligemment à une machine probabiliste. C’est la compétence pivot à acquérir maintenant.

Check list du prompt optimisé

- Rôle défini : Ai-je donné une expertise spécifique à l’IA ? (ex: « Avocat fiscaliste » vs « Avocat »)

- Cible identifiée : Ai-je précisé à qui s’adresse la réponse ?

- Verbe d’action : La tâche est-elle claire ? (rédiger, analyser, résumer, coder).

- Contexte suffisant : Ai-je donné assez d’informations » (background, objectif) ?

- Structure visuelle : Mon prompt est-il aéré (sauts de ligne, tirets, Markdown) ?

- Format de sortie (Output) : Ai-je précisé le format attendu (tableau, liste, texte court, code) ?

- Contraintes négatives : Ai-je dit ce qu’il ne faut pas faire ? (ex: « Pas de jargon », » Pas d’introduction polie « ).

- Documents de référence : Ai-je fourni les données sources pour éviter les hallucinations ?

- Chain of Thought : Ai-je demandé de » réfléchir étape par étape » (si la tâche est complexe) ?

- Auto-évaluation : Ai-je demandé à l’IA de critiquer sa propre réponse ou de vérifier sa compréhension ? Comme par exemple : » évalue ta réponse «

Quelques définitions

Les données pré-entraînées : Imaginez une vaste bibliothèque que le modèle a parcourue il y a plusieurs mois. C’est sa base de connaissances figée. Le modèle n’accède pas aux événements récents (sauf connexion web en temps réel), ni à vos données internes, à moins que vous ne les intégriez directement dans votre demande.

Le prompt engineering : Cette discipline consiste à structurer vos instructions pour guider les prédictions du modèle vers la réponse la plus pertinente possible.

La gestion de la mémoire conversationnelle : Même avec les fenêtres de contexte immenses , l’IA peut perdre le fil des instructions initiales si la conversation dérive. Ce phénomène de « dilution de l’attention » affecte la cohérence des réponses au fil des échanges.

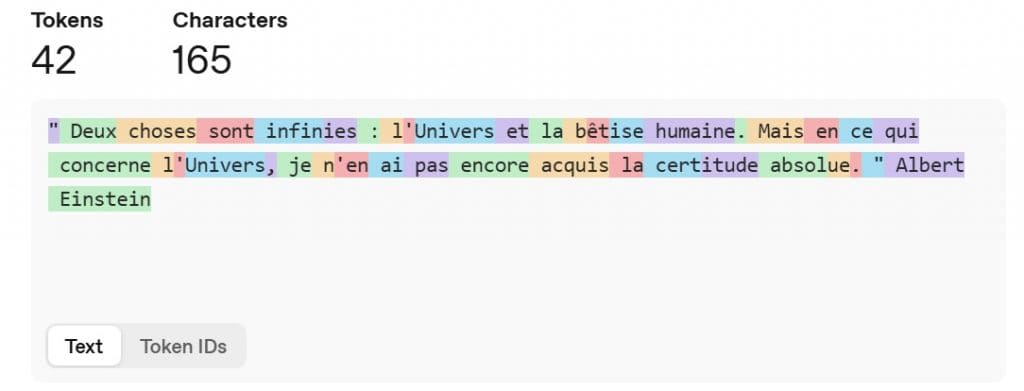

Les tokens : Le modèle ne lit pas des mots complets, mais des tokens – des fragments de texte représentant environ trois quarts d’un mot en anglais, parfois moins en français. Chaque prompt consomme donc une capacité de traitement limitée : chaque mot compte.

Pour comprendre comment un texte peut être » tokenisé » par un modèle de langage, il existe différents outils : https://platform.openai.com/tokenizer (ChatGPT), https://gptforwork.com/tools/tokenizer (ChatGPT, Gemini, Claude…), https://token-calculator.net/.

Bibliothèque de prompts

Ne réinventez pas la roue. Copiez-collez ces structures éprouvées de prompt par les équipes d'ingénierie prompt (OpenAI, Anthropic, Google DeepMind, Mistral..).

Idéal pour : La rédaction, le marketing, le code.

Prompt :

« Tu es [métier hyper précis, ex: Senior React Developer] avec [nombre] ans d’expérience chez [entreprise connue, ex: Meta].

Ta mission : [ce que tu veux exactement]

Règles strictes :

• Tu dois [obligation 1, 2, 3]

• Tu refuses absolument [interdiction claire]«

Technique : Constraint-First Prompting

Idéal pour : Les tâches techniques où le format est non-négociable.

Prompt :

« CONTRAINTES DURES (À respecter avant tout) :

- [Contrainte 1, ex: Écrit en Rust]

- [Contrainte 2, ex: Aucune dépendance externe]

- [Contrainte 3, ex: Max 500 mots]

TASK : [Description de la tâche]

Confirme que tu comprends les contraintes dures avant de commencer. »

Idéal pour : Le style, le ton, ou des formats de données spécifiques.

Prompt :

« Je veux que tu [fasses exactement ça].

Exemples de ce qu’il faut faire (Few-Shot) :

✅ BON : [exemple 1 parfait]

✅ BON : [exemple 2 parfait]

Exemples de ce qu’il NE FAUT SURTOUT PAS faire :

❌ MAUVAIS : [exemple nul]

👉 Pourquoi c’est nul : [explique en 1 phrase]«

Chain-of-Verification (CoVe)

Idéal pour : La recherche factuelle, la vérification de données.

Prompt :

« Tâche : [ta question]

Suis ce processus de vérification :

- Réponse initiale : Donne une première réponse.

- Contre-interrogatoire : Crée 5 questions qui pourraient prouver que ta réponse est fausse ou incomplète.

- Vérification : Réponds toi-même à ces 5 questions avec des faits vérifiables.

- Finale : Donne-moi la réponse finale corrigée et 100 % fiable basée sur l’étape 3. »

Idéal pour : Interroger une documentation interne ou un PDF.

Prompt :

« [CONTEXT]

[Coller ici le texte/doc]

[FOCUS]

Utilise UNIQUEMENT les informations du CONTEXT ci-dessus. Si la réponse n’y est pas, dis : ‘Information insuffisante.’ Ne fais appel à aucune connaissance externe.

[TASK]

[Votre question]«

Idéal pour : Interroger une documentation interne ou un PDF.

Prompt :

« [CONTEXT]

[Coller ici le texte/doc]

[FOCUS]

Utilise UNIQUEMENT les informations du CONTEXT ci-dessus. Si la réponse n’y est pas, dis : ‘Information insuffisante.’ Ne fais appel à aucune connaissance externe.

[TASK]

[Votre question]«

Structured Thinking Protocol

Idéal pour : Problèmes complexes, stratégie business, debug difficile.

Prompt :

« Avant de répondre, suis exactement ces 4 étapes dans l’ordre (ne saute pas d’étape) :

- [COMPRÉHENSION] Reformule la question et identifie le cœur du problème.

- [ANALYSE] Découpe le problème, liste les hypothèses et les contraintes cachées.

- [STRATÉGIE] Propose 3 approches distinctes avec avantages/inconvénients pour chacune.

- [EXÉCUTION] Choisis la meilleure approche, applique-la et donne la réponse finale.

Question : [ta vraie question ici]«

: Multi-Perspective Prompting

Idéal pour : Avoir une vue d’ensemble et éviter les angles morts.

Prompt :

« Sujet à analyser : [Sujet]

Analyse ce sujet selon 4 points de vue distincts :

- [PERSPECTIVE 1, ex: Faisabilité Technique]

- [PERSPECTIVE 2, ex: Impact Business/ROI]

- [PERSPECTIVE 3, ex: Expérience Utilisateur]

- [PERSPECTIVE 4, ex: Risque Légal/Sécurité]

SYNTHÈSE : Fais une recommandation finale en pesant les compromis (trade-offs). »

: Iterative Refinement Loop

Idéal pour : La création de contenu de haute qualité (Email, Article).

Prompt (À faire en plusieurs messages) :

- « [ITERATION 1] Crée un premier brouillon pour [Sujet]. »

- (Une fois reçu) « [ITERATION 2] Identifie 3 faiblesses ou points d’amélioration dans ce texte. »

- (Une fois reçu) « [ITERATION 3] Réécris le texte en appliquant ces corrections. »

- « [ITERATION 4] Revue finale : est-ce prêt pour la production ? Si non, affine encore. »

Meta-Prompting (L’option nucléaire)

Idéal pour : Quand on ne sait même pas comment demander.

Prompt :

« J’ai besoin d’accomplir cet objectif : [ton objectif vague]

Ta tâche :

- Analyse ce qui ferait le MEILLEUR PROMPT possible pour qu’une IA réalise cet objectif.

- Considère : la spécificité, le contexte nécessaire, les contraintes et le format de sortie.

- Écris ce prompt parfait pour moi.

- (Optionnel) Exécute-le ensuite. »